Open WebUI 是一个仿照 ChatGPT 界面,为本地大语言模型提供图形化界面的开源项目,可以非常方便的调试、调用本地模型。你能用它连接你在本地的大语言模型(包括 Ollama 和 OpenAI 兼容的 API),也支持远程服务器。Docker 部署简单,功能非常丰富,包括代码高亮、数学公式、网页浏览、预设提示词、本地 RAG 集成、对话标记、下载模型、聊天记录、语音支持等。@Appinn

测试

青小蛙实验部署了一下,只需要修改下面 Dokcer 运行命令的 API 地址:

docker run -d -p 8080:8080 -e OLLAMA_API_BASE_URL=https://API地址 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

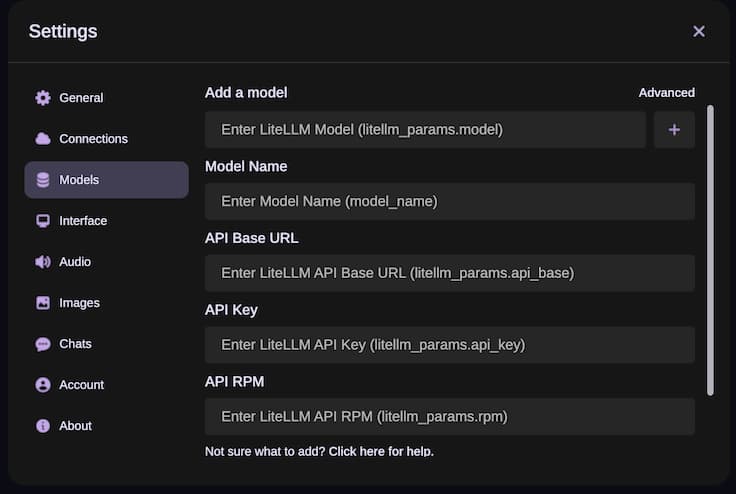

就能得到上图的界面了,然后新添加一个模型,这里要根据文档来选择,比如在 Litellm__params.model 里输入 openai/name,它就知道你使用了兼容 OpenAI API,然后根据实际情况输入其他内容,就可以使用了:

理论上来说,可以作为一个 OpenAI API 的网页客户端。

功能非常丰富

- 🖥️ 直观的界面、📱 响应式设计、⚡ 快速响应

- 🚀 采用 Docker 或 Kubernetes (kubectl、kustomize 或 helm) 安装,无任何麻烦。

- 💻代码语法高亮

- 🔢支持完整的 Markdown 和 LaTeX

- 📚 本地 RAG 集成:通过最新的检索增强生成 (RAG) 支持,深入未来的聊天交互。

- 🌐 网页浏览功能:使用#命令和网址,可以将网站无缝融入到聊天体验中。

- 📜 预设提示支持:在聊天输入中使用/命令,即可立即访问预设提示。

- 👍👎 RLHF 注解:通过对消息点赞或点踩,为创建用于人类反馈强化学习 (RLHF) 的数据集做出贡献。

- 🏷️ 对话标记

- 🗑️ 下载/删除模型

- ⬆️ GGUF 文件模型创建:通过网络界面直接上传GGUF文件轻松创建Ollama模型,提供从您的机器上上传或从Hugging Face下载GGUF文件的选项。

- 🤖 多模型支持、多模态支持

- 🧩 Modelfile构建器:通过网络用户界面轻松创建Ollama模型文件。

- ⚙️ 多模型对话:能够同时操控多个模型并结合他们的独特优势来产生最佳的回应。

- 💬 协作聊天:通过无缝编排群聊,借助多个模型的集体智能。使用@命令指定模型,在聊天界面内生成多样化动态对话。

- 🤝 OpenAI API集成:无缝集成与OpenAI兼容的API,与Ollama模型进行多功能对话。自定义API基础URL以连接LMStudio,Mistral,OpenRouter等。

- 🔄 重生记录访问

- 📜 聊天记录

- 📥 导入/导出聊天记录

- 🗣️ 语音输入支持

- ⚙️ 高级参数精细控制

- 🔗 外部Ollama服务器连接

- 🔐 基于角色的访问控制(RBAC):确保安全访问,并进行权限限制;只有获得授权的人才能访问您的Ollama,并且专门的模型创建/拉取权利仅供管理员使用。

- 🔒 后端反向代理支持:通过Open WebUI后端和Ollama的直接通信以增强安全性。该重要功能消除了在局域网上暴露Ollama的需要。来自网络用户界面的“/ollama/api”路由请求将无缝地从后端重定向至Ollama,增强整个系统的安全性。

获取

推荐给各位大模型爱好者。

原文:https://www.appinn.com/open-webui/

![Raphael AI - 世界上首个无需注册、免费无限制的 AI 绘图工具,由 FLUX.1-Dev 模型驱动[早用早享受,晚了用不到] 6 Raphael AI - 世界上首个无需注册、免费无限制的 AI 绘图工具,由 FLUX.1-Dev 模型驱动[早用早享受,晚了用不到] 5](https://www.appinn.com/wp-content/uploads/2025/01/Copy-of-appinn-homework-1-115x115.jpg)